Cos'è un RLHF?

L'apprendimento per rinforzo da feedback umano (RLHF) è una tecnica di machine learning (ML) che utilizza il feedback umano per ottimizzare i modelli di ML in modo che autoapprendano in maniera più efficiente. Le tecniche di apprendimento per rinforzo (RL) addestrano il software a prendere decisioni che massimizzino il rendimento, rendendo i risultati più accurati. L'RLHF incorpora il feedback umano nella funzione di rendimento, in modo che il modello ML possa eseguire attività più allineate agli obiettivi, ai desideri e alle esigenze umani. L'RLHF viene utilizzato in tutte le applicazioni di intelligenza artificiale generativa (IA generativa), inclusi i modelli linguistici di grandi dimensioni (LLM).

Scopri di più sul machine learning

Scopri di più sull'apprendimento per rinforzo

Perché l'RLHF è importante?

Le applicazioni dell'intelligenza artificiale (IA) sono ad ampio raggio, dalle auto a guida autonoma all'elaborazione del linguaggio naturale, dagli indicatori del mercato azionario ai servizi di personalizzazione della vendita al dettaglio. Indipendentemente dall'applicazione, l'obiettivo dell'IA è in definitiva imitare le risposte, i comportamenti e i processi decisionali umani. Il modello ML deve codificare gli input umani come dati di addestramento in modo che l'IA imiti più da vicino gli umani nel completare attività complesse.

L'RLHF è una tecnica specifica utilizzata per attribuire ai sistemi di intelligenza artificiale caratteristiche più umane, insieme ad altre tecniche come l'apprendimento supervisionato e non supervisionato. Innanzitutto, le risposte del modello vengono confrontate con le risposte di un essere umano. Successivamente un umano valuta la qualità delle diverse risposte fornite dalla macchina, attribuendo un punteggio a quelle che sembrano più umane. Il punteggio può basarsi su qualità innate umane, come la cordialità, il giusto grado di contestualizzazione e l'umore.

L'RLHF è importante per la comprensione del linguaggio naturale, ma viene utilizzato anche in altre applicazioni di IA generativa.

Scopri di più sull'intelligenza artificiale

Scopri di più sull'elaborazione del linguaggio naturale

Scopri di più sulla differenza tra apprendimento supervisionato e apprendimento non supervisionato

Migliora le prestazioni dell'IA

L'RLHF aumenta la precisione del modello ML. È possibile addestrare un modello utilizzando dati umani pre-generati, ma la presenza di ulteriori circuiti di feedback umano migliora significativamente le prestazioni del modello rispetto allo stato iniziale.

Ad esempio, quando si traduce un testo da una lingua all'altra, il modello può produrre un testo tecnicamente corretto ma poco naturale per il lettore. Un traduttore professionista può prima eseguire la traduzione, assegnando un punteggio alla traduzione generata automaticamente, per poi valutare la qualità di una serie di traduzioni generate automaticamente. Se il modello viene ulteriormente addestrato, produrrà traduzioni più naturali.

Introduce parametri di addestramento complessi

In alcune istanze, nell'IA generativa, può essere difficile addestrare accuratamente il modello per determinati parametri. Ad esempio, come si definisce lo spirito di un brano musicale? Alcuni parametri tecnici come tonalità e tempo possono delineare una certa atmosfera, ma lo spirito di un brano musicale è più soggettivo e non dipende da una serie di meri tecnicismi. È invece possibile fornire una guida umana in cui i compositori creano brani tristi ed etichettare i brani generati dalla macchina in base al livello di tristezza. Ciò consente alla macchina di apprendere questi parametri molto più rapidamente.

Migliora la soddisfazione degli utenti

Un modello ML può essere accurato, ma non è detto che sembri umano. L'RL è necessario per indirizzare il modello verso la risposta migliore e più accattivante per gli utenti umani.

Ad esempio, se si chiede a un chatbot che tempo fa fuori, la sua risposta potrebbe essere: "Ci sono 30 gradi Celsius con nuvole ed elevata umidità" oppure: "Al momento la temperatura è di circa 30 gradi. Fuori è nuvoloso e umido, quindi l'aria può sembrare più densa!". Sebbene entrambe le risposte dicano la stessa cosa, la seconda suona più naturale e fornisce più contesto.

Man mano che gli utenti umani valutano le risposte del modello che preferiscono, è possibile utilizzare l'RLHF per raccogliere feedback umani e migliorare il modello per le persone reali.

Come funziona l'RLHF?

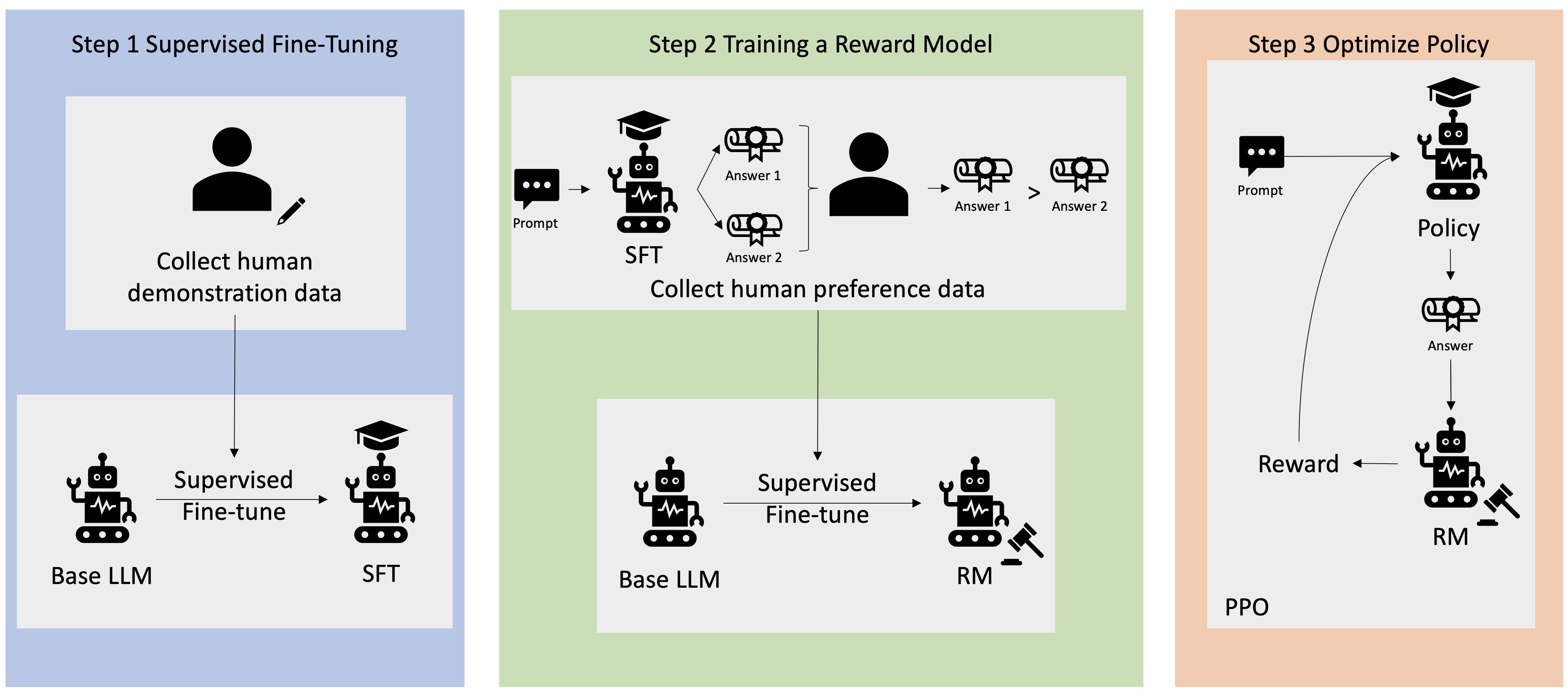

L'RLHF consiste di quattro fasi prima che il modello sia pronto. Qui utilizzeremo l'esempio di un modello linguistico, un chatbot con base di conoscenza interna all'azienda, che utilizza l'RLHF per il perfezionamento.

Forniremo solo una panoramica del processo di apprendimento. L'addestramento del modello e il perfezionamento delle politiche per l'RLHF presentano una notevole complessità matematica. Tuttavia, i processi complessi sono ben definiti in RLHF e spesso dispongono di algoritmi predefiniti che richiedono semplicemente input specifici.

Raccolta di dati

Prima di eseguire attività di ML con il modello linguistico, viene creata una serie di richieste e risposte generate da esseri umani per i dati di addestramento. Questa serie viene utilizzata successivamente nel processo di addestramento del modello.

Ad esempio, le richieste potrebbero essere:

- "Dov'è la sede del dipartimento delle risorse umane a Boston?"

- "Qual è il processo di approvazione dei post sui social media?"

- "Cosa indica il rapporto del primo trimestre sulle vendite rispetto ai rapporti trimestrali precedenti?"

Un lavoratore della conoscenza dell'azienda risponde quindi a queste domande, fornendo informazioni accurate e naturali.

Ottimizzazione supervisionata di un modello linguistico

È possibile utilizzare un modello commerciale preaddestrato come modello di base per RLHF. È possibile adattare il modello alla base di conoscenza interna dell'azienda utilizzando tecniche come la retrieval-augmented generation (RAG). Una volta ottimizzato il modello, si confronta la risposta alle richieste predeterminate con le risposte umane raccolte nella fase precedente. Le tecniche matematiche possono calcolare il grado di somiglianza tra le due.

Ad esempio, alle risposte generate dalla macchina può essere assegnato un punteggio compreso tra 0 e 1, dove 1 indica la più accurata e 0 la meno accurata. Grazie a questi punteggi, il modello dispone di una policy progettata per fornire risposte più vicine a quelle umane. Questa policy costituisce la base di tutte le decisioni future per il modello.

Creazione di un modello di rendimento separato

Il fulcro dell'RLHF è la formazione di un modello di rendimento IA separato, basato su feedback umano, e dunque l'utilizzo di questo modello come funzione di rendimento per ottimizzare la politica tramite RL. Data una serie di risposte multiple del modello che rispondono alla stessa richiesta, gli umani possono indicare la loro preferenza in merito alla qualità di ciascuna risposta. Si utilizzano queste preferenze di valutazione delle risposte per creare il modello di rendimento che stima automaticamente il punteggio che un essere umano assegnerebbe alla risposta di una determinata richiesta.

Ottimizza il modello linguistico con il modello basato sul rendimento

Il modello linguistico utilizza quindi il modello di rendimento per perfezionare automaticamente la propria politica prima di rispondere alle richieste. Utilizzando il modello di rendimento, il modello linguistico valuta internamente una serie di risposte e quindi sceglie la risposta che ha maggiori probabilità di ottenere il rendimento maggiore. Ciò significa che soddisfa maggiormente le preferenze umane.

L'immagine seguente mostra una panoramica del processo di apprendimento RLHF.

Come viene utilizzato l'RLHF nel campo dell'IA generativa?

L'RLHF è noto come la tecnica standard del settore per garantire che gli LLM producano contenuti veritieri, innocui e utili. Tuttavia, la comunicazione umana è un processo soggettivo e creativo e l'utilità dei risultati dell'LLM è profondamente influenzata dai valori e dalle preferenze umane. Ogni modello viene addestrato in modo leggermente diverso e si avvale di intervistati umani diversi. Per questo motivo, i risultati differiscono anche tra LLM competitivi. Il grado in cui ogni modello integra i valori umani dipende del tutto dal creatore.

Le applicazioni di RLHF si estendono oltre i limiti degli LLM ad altri tipi di IA generativa. Ecco alcuni esempi:

- L'RLHF può essere utilizzato nella generazione di immagini IA, ad esempio, per valutare il grado di realismo, la tecnicità o l'atmosfera di un'opera d'arte

- Nella generazione di musica, l'RLHF consente di creare musica che attribuisca determinati stati d'animo e colonne sonore alle attività

- L'RLHF può essere utilizzato in un assistente vocale, attribuendo alla voce un tono più amichevole, curioso e affidabile

In che modo AWS può supportare i tuoi requisiti di RLHF?

Amazon SageMaker Ground Truth offre il set più completo di funzionalità human-in-the-loop per incorporare il feedback umano in tutto il ciclo di vita del ML allo scopo di migliorare la precisione e la pertinenza dei modelli. È possibile completare varie attività human-in-the-loop, dalla generazione e annotazione dei dati alla generazione di modelli di rendimento, revisione e personalizzazione di modelli tramite un'offerta self-service o gestita da AWS.

SageMaker Ground Truth include un annotatore di dati per le funzionalità RLHF. È possibile fornire un feedback diretto e una guida sull'output generato da un modello tramite la classificazione e la valutazione (o entrambe le opzioni) delle risposte ai risultati dell'RL. I dati, denominati dati di confronto e classificazione, rappresentano effettivamente un modello di rendimento o una funzione di rendimento, utilizzata poi per addestrare il modello. È possibile utilizzare i dati di confronto e classificazione per personalizzare un modello esistente per il proprio caso d'uso o per ottimizzare un modello creato da zero.

Inizia subito a utilizzare le tecniche RLHF su AWS creando un account.

Fasi successive su AWS

Ottieni accesso istantaneo al Piano gratuito di AWS.